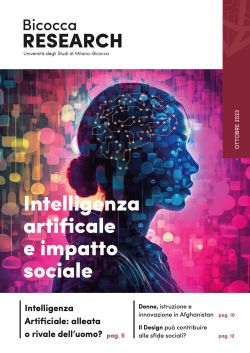

Approfondimento di IA, comprendere i potenziali rischi per evitare o mitigare l’impatto sociale

Il Parlamento europeo sta per approvare un regolamento sull’Intelligenza Artificiale (AI) in cui di essa viene data la definizione chiara di “sistemi le cui predizioni, contenuti e decisioni hanno la capacità di influenzare gli ambienti in cui operano e gli utenti che le adoperano”. Dalla definizione stessa risulta chiaro quanto sia necessario regolamentarne l’utilizzo in tutti gli Stati dell’UE e diffondere la consapevolezza tra i cittadini sull’impatto etico di queste tecnologie, per come esse mediano l’accesso alle informazioni, supportano il lavoro e facilitano l’interazione con i servizi digitali. Per esempio, in ambito sanitario l’IA può ridurre errori diagnostici ma pone anche interrogativi etici su chi sia responsabile in caso di errore e sulla possibile dequalificazione del personale, se questo si affida troppo ad assistenti robotici di altissima affidabilità e precisione.

In ambito legale, l’IA può accelerare attività di analisi documentale e istruttoria ma desta preoccupazioni la sua imparzialità e anche l’impatto sull’autonomia decisionale di giudici e inquirenti. È quindi chiaro che vada garantita equità e non discriminazione, anche con strumenti di valutazione d’impatto algoritmico, tra i quali quello sviluppato presso il laboratorio MUD di questo Ateneo e adottato dal suo spin-off Red Open. Inoltre, l’IA generativa può generare notizie false su chiunque e violare i diritti d’autore: è quindi fondamentale un suo uso etico e responsabile, comprendendo i rischi connessi e i modi per mitigarli efficacemente.

Università, centri di ricerca e settore privato devono impegnarsi tutti a diffondere questa sensibilità verso i grandi cambiamenti socio-tecnologici che la IA abilita o promuove, formando i professionisti del futuro e sensibilizzando l’opinione pubblica a una cultura della responsabilità e della IA centrata sull’uomo e sui suoi diritti.